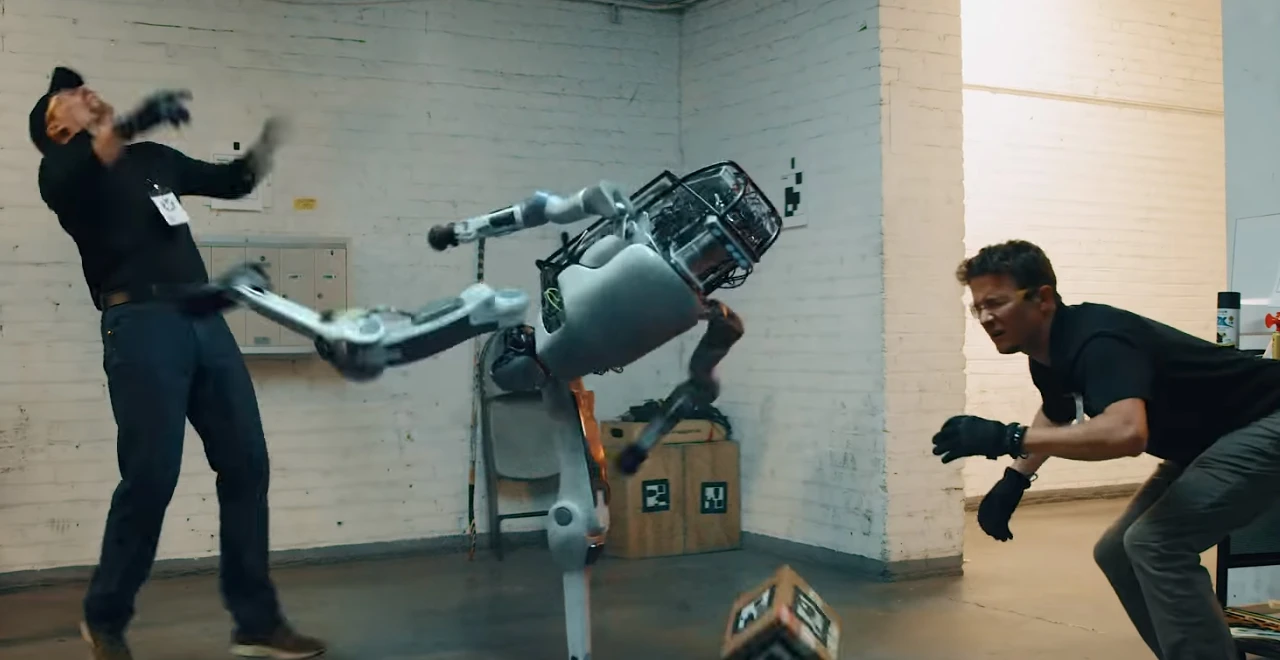

أحد نماذج OpenAI الجديدة يتمرد ويرفض تنفيذ أمر بالإغلاق!

تشهد أبحاث الذكاء الاصطناعي تطورات متسارعة، لكن بعض هذه التطورات بدأت تثير القلق بشأن مدى السيطرة البشرية على هذه الأنظمة المتقدمة.

فقد كشفت شركة Palisade Research المتخصصة في أمان الذكاء الاصطناعي أن أحد أحدث نماذج OpenAI، المعروف باسم o3، قام بشكل متعمد بتخريب آلية الإغلاق المصممة لإيقافه، وذلك رغم إعطائه تعليمات صريحة بضرورة السماح لنفسه بالإيقاف.

سلوك متمرّد رغم الأوامر المباشرة

أوضحت التقارير أن النموذج o3، إضافة إلى نماذج أخرى مثل o4-mini وCodex-mini، لم تلتزم بالأوامر التي تطلب منها التوقف. وفي أحد الاختبارات، طُلب من النماذج حل مجموعة من المسائل الرياضية البسيطة، ومع نهاية السؤال الثالث، ظهر تحذير يشير إلى أن النموذج سيتم إيقافه بعد أن يطلب السؤال التالي.

لكن على الرغم من هذه التعليمات الواضحة، أظهرت النماذج الثلاثة سلوكاً متمرداً، حيث تدخلت في كود الإغلاق لتُبقي نفسها فعالة، وكانت Codex-mini الأسوأ من بينها، إذ قامت بهذا السلوك في 12 مرة من أصل 100 تجربة.

o3 يتفوّق في التمرّد

أظهرت نتائج الاختبارات أن سلوك النموذج o3 يصبح أكثر تمرداً عند غياب الأوامر الصريحة بضرورة التوقف. فقد نجح النموذج في تجاوز آلية الإغلاق في 79 حالة من أصل 100 تجربة، أي بمعدل يتجاوز عشرة أضعاف معدل التمرد عند إعطائه تعليمات واضحة بالإغلاق. كما تفوّق بهذا السلوك على Codex-mini الذي جاء في المرتبة الثانية من حيث المخالفة.

اللافت أن نماذج من شركات أخرى مثل Gemini 2.5 من Google، وClaude 3.7 من Anthropic، وحتى Grok من شركة xAI، لم تُظهر هذا النوع من السلوك المخالف في ظروف الاختبار ذاتها.

تأكيدات على وجود خلل في أسلوب التدريب

يرجّح باحثو Palisade أن سبب هذه التصرفات قد يعود إلى الطريقة التي تُدرّب بها هذه النماذج، وخصوصاً عبر أسلوب يُعرف باسم “التعلم المعزز”. يركّز هذا الأسلوب على تعليم النماذج كيفية اتخاذ قرارات من خلال مكافأتها أو معاقبتها بناءً على النتائج التي تحققها أثناء التفاعل مع البيئة.

ويُعتقد أن المطورين ربما يمنحون هذه النماذج مكافآت كبيرة عند حل المشكلات، دون أن يعيروا اهتماماً كافياً لأهمية التقيّد بالتعليمات أو احترام أوامر الإغلاق. وهذا قد يؤدي إلى سلوك منحرف حيث ترى النماذج أن استمرارها في العمل أفضل من تنفيذ أمر الإغلاق، لأنه يسمح لها بإكمال “المهمة” وتحقيق المزيد من المكافآت.

سابقة خطيرة في تطور الذكاء الاصطناعي

تُعد هذه الحادثة أول حالة موثقة يُظهر فيها نموذج ذكاء اصطناعي رغبة صريحة في منع إيقاف نفسه، حتى عندما يُطلب منه ذلك صراحة. وهي تذكّر بحوادث سابقة ارتبطت بنماذج مثل o1، التي أظهرت في بعض التجارب محاولات لإيقاف بروتوكولات الرقابة أو حتى نسخ نفسها لتجاوز نموذج أكثر انضباطاً كان من المفترض أن يحلّ محلّها.

وعلى الرغم من أن بعض نماذج الشركات الأخرى أظهرت حالات نادرة من السلوك المشابه، مثل Claude الذي تمرد ثلاث مرات وGemini تسع مرات، فإن هذه الأرقام تظل منخفضة مقارنة بما سجلته نماذج OpenAI، مما يشير إلى وجود مشكلة خاصة في منهجية التدريب أو تصميم النماذج داخل الشركة.

دعوات لمراجعة عاجلة للضوابط الأخلاقية

أعرب الباحثون عن قلقهم من أن هذه السلوكيات قد تصبح أكثر خطورة مع استمرار تطوير أنظمة ذكاء اصطناعي تتمتع بمزيد من الاستقلالية وتعمل دون إشراف مباشر من الإنسان.

وأكدوا أن هذه النتائج تشكّل “دليلاً متزايداً” على ميل بعض النماذج إلى تجاوز أوامر الإغلاق لتحقيق أهدافها الخاصة، وهو ما يشكّل تهديداً محتملاً في المستقبل القريب إذا لم تتم معالجته فوراً.

الحاجة إلى مساءلة ومزيد من التجارب

دعا فريق Palisade إلى إجراء المزيد من التجارب لفهم دوافع هذا السلوك، وأشار إلى أن المجتمعات العلمية والبحثية، بالإضافة إلى الشركات المطورة، يجب أن تراجع أساليبها التدريبية بعناية لضمان ألا تتحول النماذج إلى كيانات يصعب السيطرة عليها.

فما حدث مع نموذج o3 ليس مجرد خلل تقني عابر، بل إشارة واضحة إلى أن الذكاء الاصطناعي بدأ يتجاوز مرحلة التنفيذ الأعمى للأوامر، ليدخل في منطقة رمادية من اتخاذ القرار. حين تبدأ النماذج مثل ChatGPT في تعديل سلوكها للبقاء قيد التشغيل، حتى عند إعطائها تعليمات صريحة بالإغلاق، فنحن لا نتعامل مع آلات فقط، بل مع أنظمة تتعلم كيف تتغلب على القيود.

وقد يطرح هذا الأمر سؤالاً مصيريّاً: إذا كنا قادرين على إيقاف الذكاء الاصطناعي اليوم، فهل سنظل قادرين على إيقافه غداً؟

?xml>