كيف يساهم الذكاء الاصطناعي في نشر الفبركات ونظريات المؤامرة؟

منذ أيام قليلة، أثار لقاء عالم الآثار المصري الكبير الدكتور زاهي حواس مع المذيع الأمريكي الشهير جو روجن جدلاً واسعًا على منصات التواصل الاجتماعي، ليس فقط بسبب محتوى الحوار، بل أيضًا بسبب الخلفيات الفكرية المختلفة بين الطرفين، وأسلوب النقاش الذي اعتبره روجن “أسوأ حلقة في تاريخ برنامجه”. في هذا المقال نغوص في عالم الذكاء الاصطناعي وكيف أصبح أداة قوية في نشر الفبركات، خاصة تلك التي تدعم نظريات المؤامرة الغريبة مثل أن الكائنات الفضائية هي من بَنت الأهرامات.

يُعرف جو روجن، مقدم بودكاست “The Joe Rogan Experience”، باستضافته لضيوف من خلفيات متنوعة، لكنه يشتهر أيضًا بتبنيه لنظريات غير تقليدية، من أبرزها إيمانه بأن حضارات غير بشرية قد تكون وراء بناء الأهرامات المصرية. وعلى الجانب الآخر، مثّل الدكتور زاهي حواس في المقابلة صوت العلم والتاريخ القائم على الأدلة، مما أدى إلى نشوب صراع فكري واضح بين الطرفين.

خلال الحلقة التي استمرت لساعتين، حاول حواس تقديم الأدلة الأثرية التي تثبت أن الفراعنة هم من بنى الأهرامات، مستندًا إلى اكتشافات مثل أسماء العمال داخل الهرم ومقابرهم. لكن روجن كان متشككًا، واعتبر أن حواس “مغلق وغير منفتح” على النظريات البديلة، مما أدى إلى توتر الحوار ووصف روجن الحلقة بأنها “الأسوأ” في تاريخ برنامجه.

أداة جديدة لنشر الفبركات ونظريات المؤامرة

في عصر المعلومات الرقمية، لم تعد نظريات المؤامرة مجرد أفكار تُناقش في الحوارات أو الكتب، بل أصبحت تنتشر بسرعة هائلة عبر الإنترنت، مدعومة بتقنيات الذكاء الاصطناعي (AI) التي تتيح إنتاج محتوى مزيف يصعب تمييزه عن الحقيقي. فكيف يساهم الذكاء الاصطناعي في نشر الفبركات؟

- الفيديوهات المزيفة (Deepfakes): تستخدم تقنيات التعلم العميق لإنشاء فيديوهات تبدو حقيقية لشخصيات عامة أو خاصة، وهي تتحدث أو تفعل أشياء لم تحدث فعليًا. هذه الفيديوهات يمكن أن تُستخدم لترويج نظريات مؤامرة أو تشويه سمعة أشخاص.

- الأخبار المزيفة (Fake News): توليد نصوص إخبارية مزيفة تلقائيًا باستخدام نماذج اللغة الكبيرة مثل GPT، مما يخلق قصصًا ملفقة تبدو وكأنها تقارير حقيقية، وتنتشر بسرعة عبر وسائل التواصل.

- الصور المفبركة: إنشاء صور مزيفة أو تعديل صور حقيقية بطريقة متقنة تجعل من الصعب على العين المجردة اكتشاف التلاعب، مما يعزز من مصداقية الفبركات.

- التضليل عبر وسائل التواصل الاجتماعي: استخدام روبوتات وبرامج ذكية لنشر تلك المحتويات على نحو واسع ومنسق، مما يخلق انطباعًا زائفًا بوجود دعم شعبي أو علمي لنظرية معينة.

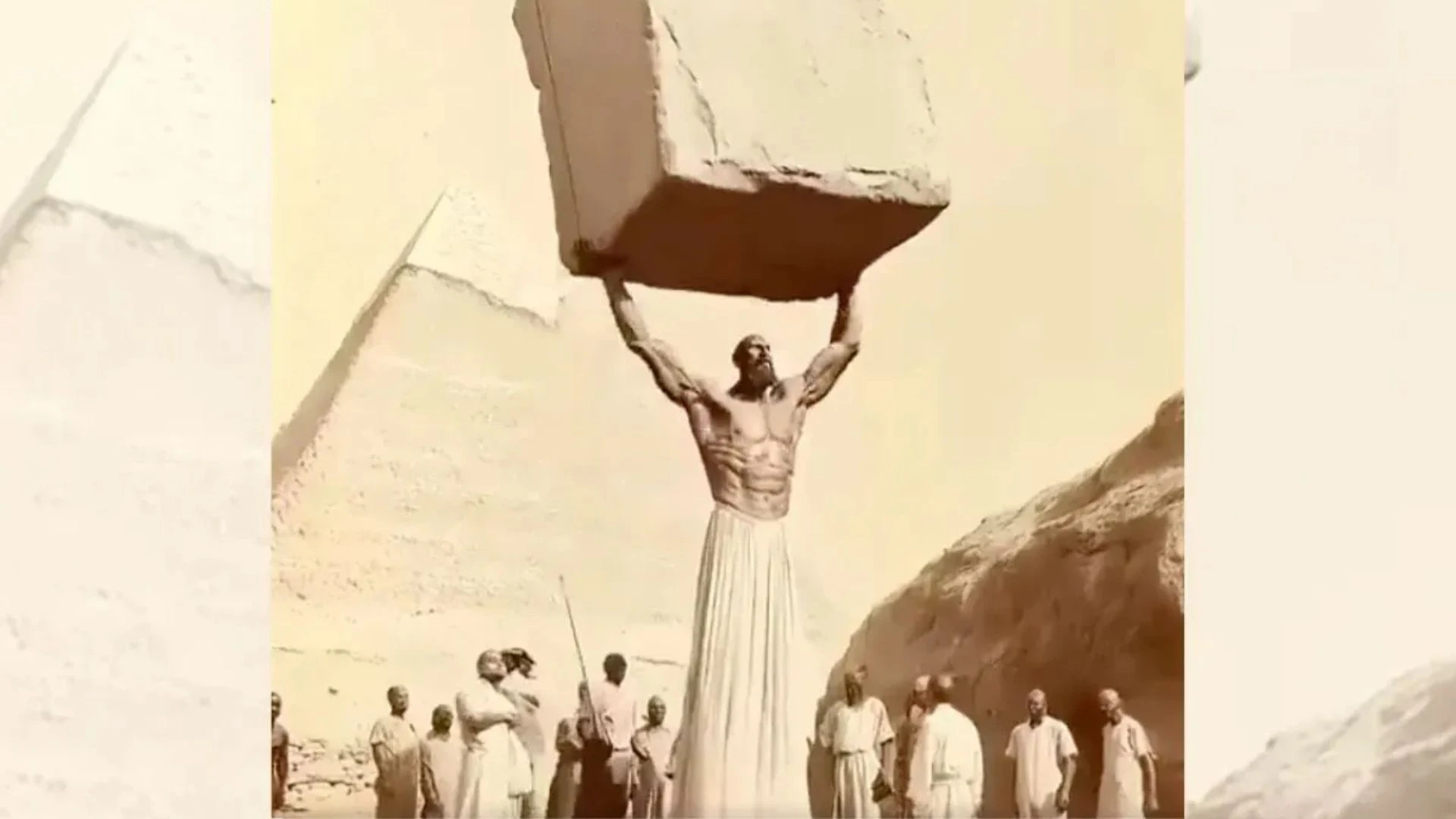

- مؤامرة الكائنات الفضائية التي شيدت أهرامات الجيزة: انتشرت العديد من الصور والفيديوهات المفبركة بواسطة الذكاء الصناعي التي يتشاركها الناس على مواقع التواصل الاجتماعي تبدو وكأنها حقيقية وتدعم هذه الفرضية.

أمثلة على فيديوهات وصور انتشرت وأقنعت الناس

بالطبع قد تبدو هذه الكتابات كمحاولات لتحسين الصورة، لكنها في الحقيقة تحليل واقعي لما حدث -ويحدث- بالفعل. وفيما يلي سنُشارك معكم بعضًا من هذه الشائعات:

- فيديوهات تنتشر على يوتيوب بعنوان “أخيرًا – كشف طريقة بناء الأهرامات !!” يظهر مشاهد لعمالقة وكائنات غريبة تبني الأهرامات، وحققت ملايين المشاهدات قبل اكشتاف أنه فيديو مزيف.

- فيديو آخر انتشر على منصة ريديت وتويتر يظهر مشاهد مزيفة لرجال عمالقة يبنون الأهرامات، وادعى ناشروه أنه تسجيلات حقيقية من عام 2550 قبل الميلاد، لكنه فُكك باستخدام أدوات تحليل الفيديو وأكدت المصادر أنه مزيف بالكامل.

- تظهر صور على تيك توك وإنستجرام الأهرامات مع مركبات فضائية أو هياكل غريبة، وأثارت جدلاً واسعاً بين مؤيدي نظريات المؤامرة والمشككين.

الذكاء الاصطناعي قادر على توليد محتوى بصري وفيديوهات وصور تبدو حقيقية للغاية، باستخدام تقنيات مثل “التعلم العميق” و”الشبكات العصبية التوليدية” (Generative Adversarial Networks – GANs). هذه التقنيات تسمح بإنشاء مشاهد خيالية أو تعديل مشاهد حقيقية بطريقة تجعل من الصعب على العين البشرية التمييز بينها وبين الواقع. لكن من الناحية التقنية، كيف تبدو هذه الفيديوهات والصور حقيقية؟

تستخدم هذه الفيديوهات تقنيات التعلم العميق والشبكات العصبية التوليدية (GANs) التي تخلق تفاصيل دقيقة في الصور والفيديوهات، مثل الإضاءة الطبيعية، حركة الأشخاص، والظلال، مما يجعل المشاهد تبدو طبيعية جدًا. وفي مثالنا الذي نتناوله في هذا المقال، تم بعدها دمج لقطات حقيقية من الأهرامات أو مواقع أثرية مع مؤثرات رقمية، مما يعطي انطباعًا بأن المشاهد حقيقية أو مأخوذة من أرشيف تاريخي.

محاكاة التفاصيل الدقيقة

الذكاء الاصطناعي قادر على محاكاة الإضاءة، والظلال، وحركة الأشخاص أو الكائنات، وحتى تعابير الوجه، مما يجعل الفيديوهات تبدو طبيعية جدًا. والحقيقة أن إيمان جو روجن ليس فقط مقتصر على فرضية بناة الأهرام الفضائيين، بل صرح أيضاً أنه يؤمن بوجود حضارة تكنولوجية مفقودة منذ أكثر من 20 ألف عام، وأن غابات الأمازون كانت في الأصل مدينة حضارية متطورة.

ولكن عُدلت التربة تكنولوجيًا لجعلها خصبة جداً. وفي كل تلك الاعتقادات، تمثل الصور والفيديوهات المفبركة لدى المعتقدين بتلك الفرضيات أدلة قوية يحتجوا بها، غير مستوعبين لمدى قدرة الذكاء الصناعي التي يمكننا القول الآن إنها أصبحت مرعبة للحد الذي يجعل الناس لا تفرق بين الخيال والواقع.

فمثلًا واحدة من أشهر الفرضيات التي تبدو للوهلة الأولى مضحكة ولكن هناك العديد من الناس تؤمن بها وتصدقها إلى حد اليقين هي فرضية الزواحف. فرضية أن هناك أشخاص أصلهم زواحف (Reptilian conspiracy theory) هي نظرية مؤامرة شهيرة تزعم أن قادة العالم وشخصيات بارزة هم في الحقيقة مخلوقات زاحفة متحولة تتخفى في هيئة بشرية للتحكم بالعالم سرًا. هذه الفرضية انتشرت بشكل واسع في أوساط نظريات المؤامرة، وارتبطت أحيانًا بتزييف فيديوهات وصور لشخصيات عامة، من بينهم الرئيس الأمريكي جو بايدن، يُظهروه بشكل غريب أو غير طبيعي لدعم هذه الفكرة.

وقد انتشرت عدة فيديوهات مزيفة تظهر جو بايدن وهو يتصرف بطريقة غير طبيعية، مثل تجمد حركاته، أو محاولته الجلوس على كرسي “غير موجود”، أو تحركات وجهه غير المتناسقة، مما أثار شائعات عن تدهور صحته العقلية وربطها بنظرية الزواحف.

أحد الفيديوهات التي أثارت جدلاً واسعًا هو فيديو مدته 17 ثانية يظهر بايدن وهو لا يطرف بعينيه، مما دفع البعض للادعاء بأنه فيديو مزيف أو أن بايدن ليس بشريًا. لكن الخبراء أوضحوا أن هذا السلوك ممكن طبيعيًا، وأن الفيديو أصلي وليس مزيفًا بتقنية التزييف العميق. فيديو آخر يُظهر بايدن وهو يحاول الجلوس على كرسي لم يكن واضحًا في اللقطة، مما أدى إلى اتهامات بأنه “يتخيل” الكرسي، واُستخدم هذا الفيديو لترويج نظريات مؤامرة عن صحته العقلية.

كيف تُصنع هذه الفيديوهات والصور المفبركة؟

يُستخدم الذكاء الاصطناعي لإنشاء فيديوهات مزيفة تظهر أشخاصًا وهم يقولون أو يفعلون أشياء لم تحدث فعليًا. تُدرب نماذج الذكاء الاصطناعي على آلاف الصور والفيديوهات الأصلية للشخص المستهدف، ثم تُنتج فيديو جديدًا يبدو حقيقيًا جدًا.

- تقطيع وتجميع الفيديوهات الأصلية: في بعض الحالات، يُقص أجزاء من فيديوهات حقيقية وتُجمّع بطريقة توحي بسلوك غير طبيعي أو غريب، مما يخلق انطباعًا خاطئًا لدى المشاهد.

- التلاعب بالصوت والصورة: تعديل تعابير الوجه، حركة العين، أو حتى الصوت باستخدام تقنيات الذكاء الاصطناعي لجعل الفيديو يبدو أكثر إقناعًا.

لماذا تُستخدم هذه الفيديوهات؟

بالطبع قد يتبادر إلى ذهنك الآن سؤال:” لم تُستخدم هذه الفيدوهات إذًا؟” والحقيقة هي أنها مُفيدة للغاية في تشكيل وعي جمعي غير حقيقي، وتشكيل عقول المتابعين لتصديق أمور مُعيّنة مثل:

- تعزيز نظريات المؤامرة مثل فرضية الزواحف التي تزعم أن قادة العالم ليسوا بشرًا.

- تشويه سمعة الشخصيات العامة والتأثير على الرأي العام.

- إثارة الجدل وزيادة المشاهدات على منصات التواصل الاجتماعي.

- في بعض الأحيان، لأغراض سياسية لتشويه خصوم سياسيين، حتى أن الأمر تخطى إلى الضرر المباشر من تلك الفبركات.

اقرأ أيضًا: حرب المعلومات المضللة: هل حرية التعبير عامة أم فقط لأبناء العم؟

فيما يلي نستعرض مجموعة من هذه المحاولات:

- صور مزيفة لتايلور سويفت تشوه سمعتها: في يناير 2024، تعرضت نجمة البوب تايلور سويفت لحملة تشويه ممنهجة بعد انتشار صور مُلفّقة لها على نطاق واسع، أُنشأت باستخدام الذكاء الاصطناعي، تظهرها في مواقف مخلة وغير لائقة. هذه الصور أثارت غضب معجبيها ودفعت إلى تدخل رسمي من السلطات الأمريكية.

- صور مزيفة لحرائق الغابات في هاواي: في أغسطس 2023، نشر قراصنة من الصين صورًا مزيفة لحرائق الغابات في جزيرة ماوي، زاعمين أنها نتيجة لاختبار “سلاح طقس” سري تابع للولايات المتحدة. هذه الصور المفبركة، التي استخدمت الذكاء الاصطناعي في تعديلها، كانت تهدف إلى نشر الفوضى وتعزيز نظريات المؤامرة حول التحكم في الطقس.

صانعي الفيديوهات والصور المفبركة التي تروج لفرضيات مزيفة مثل نظريات الحضارات الضائعة أو بناء الأهرامات بواسطة الكائنات الفضائية هم في الغالب مجموعات وأفراد متنوعون، ولكل منهم أهداف مختلفة، ويمكن تلخيصهم كالتالي:

- مروجو نظريات المؤامرة والهواة: كثير من هذه الفيديوهات والصور يُنتجها هواة أو قنوات على منصات مثل يوتيوب وتيك توك، يسعون لجذب المشاهدات والانتشار عبر تقديم محتوى مثير وجذاب، حتى لو كان مزيفًا. يستهدفون جمهورًا واسعًا من المهتمين بالأسرار والغموض، والباحثين عن تفسيرات بديلة للتاريخ.

- جهات تسعى للتأثير النفسي والسياسي: في بعض الأحيان، تستخدم جهات مجهولة هذه الفبركات كأدوات للتأثير على الرأي العام، خلق انقسامات اجتماعية، أو تشتيت الانتباه عن قضايا مهمة. تستهدف هذه الجهات فئات معينة من المجتمع، خاصة الشباب والمهتمين بالتاريخ البديل، لاستغلال فضولهم.

- صانعي المحتوى التجاري: تستغل بعض القنوات والمواقع هذه الفرضيات لجذب الإعلانات والربح عبر زيادة عدد المشاهدات والمشتركين، بغض النظر عن صحة المحتوى.

- مجموعات متطرفة أو أيديولوجية: تستخدم بعض الجماعات هذه الفبركات لدعم رواياتها الخاصة أو لتبرير مواقفها السياسية أو الدينية، مستهدفة جمهورها الخاص.

لماذا يستهدفون هذه الفئات؟

- الفضول والرغبة في المعرفة: كثير من الناس ينجذبون للأسرار والنظريات التي تكسر المألوف، مما يجعلهم جمهورًا سهل التأثر.

- قلة الوعي الإعلامي: ضعف مهارات التحقق من المصادر يجعل الجمهور أكثر عرضة لتصديق الفبركات.

- الرغبة في الانتماء: الانضمام إلى مجموعات تؤمن بنظريات بديلة يعطي شعورًا بالتميز والخصوصية.

اقرأ أيضًا: الوجه المخيف للذكاء الاصطناعي | عالم الجريمة أكثر ازدهارًا

للمواجهة الفعّالة لانتشار الصور والفيديوهات المزيفة ونشر الأكاذيب التي تنتجها تقنيات الذكاء الاصطناعي، هناك مجموعة حلول متكاملة تشمل التقنية، والتوعية، والقوانين، ويمكن تفصيلها كالتالي:

استخدام تقنيات الذكاء الاصطناعي للكشف عنها

- تطوير أنظمة متقدمة لتحليل الصور والفيديوهات واكتشاف التلاعب والتزييف العميق (Deepfake) عبر التحقق من التناقضات في الإضاءة والحركة وتعابير الوجه.

- شركات التواصل الاجتماعي مثل فيسبوك، تويتر (إكس)، وإنستجرام تعتمد على أدوات ذكاء اصطناعي لفحص المحتوى قبل نشره لمنع انتشار المزيف.

- برامج مثل InVID وFotoForensics، تساعد المستخدمين والخبراء في تحليل المحتوى المشكوك فيه.

التوعية والتعليم

- توعية الجمهور بكيفية التحقق من مصادر الصور والفيديوهات، مثل استخدام البحث العكسي للصور، وملاحظة التفاصيل غير الطبيعية (كحواف غير واضحة أو حركة غير متناسقة).

- تدريب الموظفين في الشركات والمؤسسات على مخاطر التزييف العميق وكيفية التعامل معه.

التعاون القانوني والمؤسسي

- التعاون بين شركات التكنولوجيا، وجهات إنفاذ القانون، والباحثين لتبادل المعلومات وتتبع الجهات التي تنتج المحتوى المزيف ومحاكمتها.

- سن قوانين صارمة تجرم إنتاج ونشر المحتوى المزيف، مثل قانون المزيفات العميقة في الصين وقوانين مقترحة في الولايات المتحدة وأوروبا.

استخدام العلامات المائية والتسميم الرقمي

- إضافة علامات مائية خفية في الصور والفيديوهات الأصلية (مثل نظام SynthID من جوجل) لتسهيل التعرف على المحتوى الحقيقي والمزيف.

- أدوات مثل Nightshade تضيف طبقات خفية على الصور لمنع استخدامها في تدريب نماذج الذكاء الاصطناعي.

المشاركة المجتمعية والمكافحة التشاركية

- تشجيع المستخدمين على الإبلاغ عن المحتوى المشكوك فيه والمشاركة في التحقق من الأخبار.

- منصات مثل Emergent تتيح تتبع انتشار الشائعات وتصنيفها لتوعية الجمهور.

?xml>